İşletmeler, sınırlı prototiplerde üretken yapay zekayı denemekten bunları üretime geçirmeye geçtikçe, fiyat konusunda giderek daha bilinçli hale geliyorlar. Sonuçta büyük dil modellerini kullanmak ucuz değil. Maliyeti azaltmanın bir yolu eski bir kavrama geri dönmektir: önbelleğe alma. Bir diğeri ise daha basit sorguları daha küçük, daha uygun maliyetli modellere yönlendirmektir. AWS bugün Las Vegas’taki re:invent konferansında Bedrock LLM barındırma hizmeti için bu özelliklerin her ikisini de duyurdu.

Öncelikle önbellekleme hizmetinden bahsedelim. “Diyelim ki bir belge var ve birden fazla kişi aynı belge üzerinde sorular soruyor. Bedrock’un ürün müdürü Atul Deo bana “Her seferinde ödeme yapıyorsunuz” dedi. “Ve bu bağlam pencereleri giderek daha da uzuyor. Örneğin Nova ile 300 bine sahip olacağız [tokens of] bağlam ve 2 milyon [tokens of] bağlam. Gelecek yıl bu rakamın çok daha yüksek seviyelere çıkabileceğini düşünüyorum.”

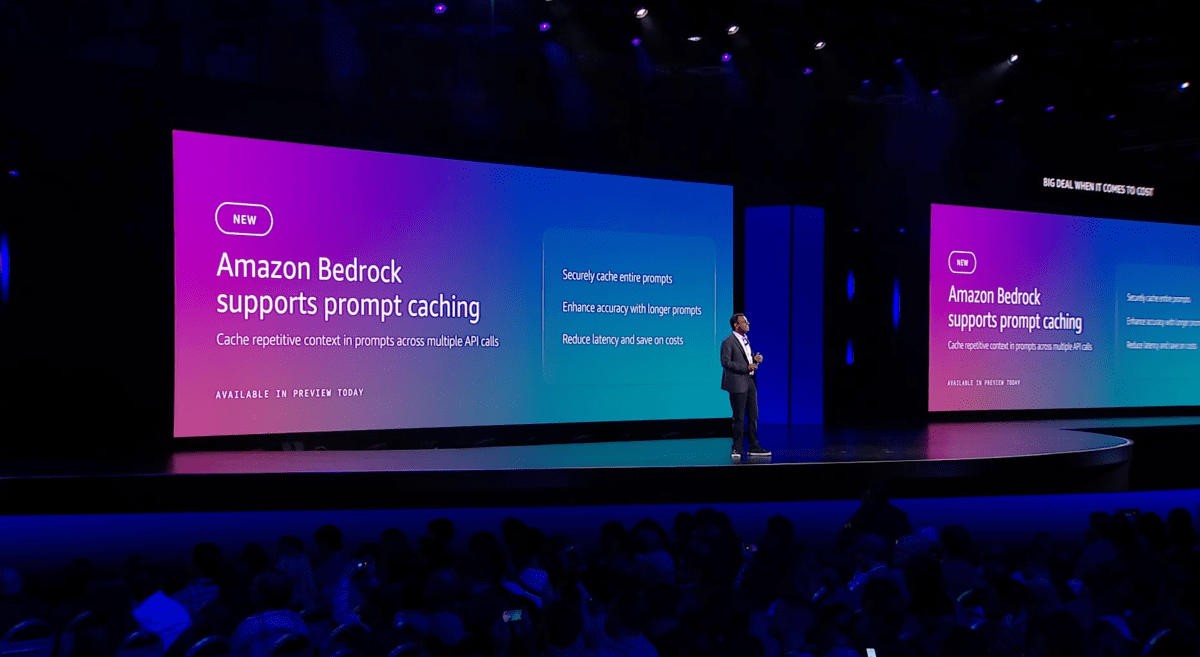

Önbelleğe alma, temel olarak modelin tekrarlayan işler yapması ve aynı (veya büyük ölçüde benzer) sorguları tekrar tekrar işlemesi için ödeme yapmanıza gerek kalmamasını sağlar. AWS’ye göre bu, maliyeti %90’a kadar azaltabilir ancak bunun ek bir yan ürünü de modelden yanıt alma gecikmesinin önemli ölçüde daha düşük olmasıdır (AWS, %85’e kadar olduğunu söylüyor). Bedrock’taki bazı üretken yapay zeka uygulamaları için hızlı önbelleğe almayı test eden Adobe, yanıt süresinde %72’lik bir azalma gördü.

Diğer önemli yeni özellik ise Bedrock için akıllı yönlendirmedir. Bu sayede Bedrock, işletmelerin performans ve maliyet arasında doğru dengeyi kurmasına yardımcı olmak için istemleri aynı model ailesindeki farklı modellere otomatik olarak yönlendirebilir. Sistem, her modelin belirli bir sorgu için nasıl performans göstereceğini (küçük bir dil modeli kullanarak) otomatik olarak tahmin eder ve ardından isteği buna göre yönlendirir.

“Bazen sorgum çok basit olabiliyor. Bu sorguyu gerçekten son derece pahalı ve yavaş olan en yetenekli modele göndermem gerekiyor mu? Muhtemelen hayır. Yani temel olarak ‘Hey, çalışma zamanında, gelen istemi temel alarak doğru sorguyu doğru modele gönder’ fikrini yaratmak istiyorsunuz” diye açıkladı Deo.

LLM yönlendirme elbette yeni bir kavram değil. Martian gibi start-up’lar ve bir dizi açık kaynak proje de bu sorunla mücadele ediyor ancak AWS muhtemelen teklifini farklı kılan şeyin, yönlendiricinin çok fazla insan girişi olmadan sorguları akıllıca yönlendirebilmesi olduğunu iddia edecek. Ancak sorguları yalnızca aynı model ailesindeki modellere yönlendirebilmesi nedeniyle de sınırlıdır. Ancak Deo bana uzun vadede ekibin bu sistemi genişletmeyi ve kullanıcılara daha fazla kişiselleştirilebilirlik sağlamayı planladığını söyledi.

Son olarak AWS, Bedrock için yeni bir pazar yeri de başlatıyor. Deo’ya göre buradaki fikir, Amazon’un daha büyük model sağlayıcıların çoğuyla ortaklık yapmasına rağmen, artık yalnızca birkaç özel kullanıcıya sahip olabilecek yüzlerce özel modelin var olmasıdır. Bu müşteriler şirketten bunları desteklemesini istediğinden, AWS bu modeller için bir pazar başlatıyor; buradaki tek büyük fark, kullanıcıların altyapılarının kapasitesini kendilerinin tedarik etmesi ve yönetmesi gerektiğidir; Bedrock bunu genellikle otomatik olarak yönetir. AWS, bu yeni ortaya çıkan ve özel modellerden toplamda yaklaşık 100 adet sunacak ve daha fazlası da gelecek.

Kaynak: https://techcrunch.com/2024/12/04/aws-brings-prompt-routing-and-caching-to-its-bedrock-llm-service/