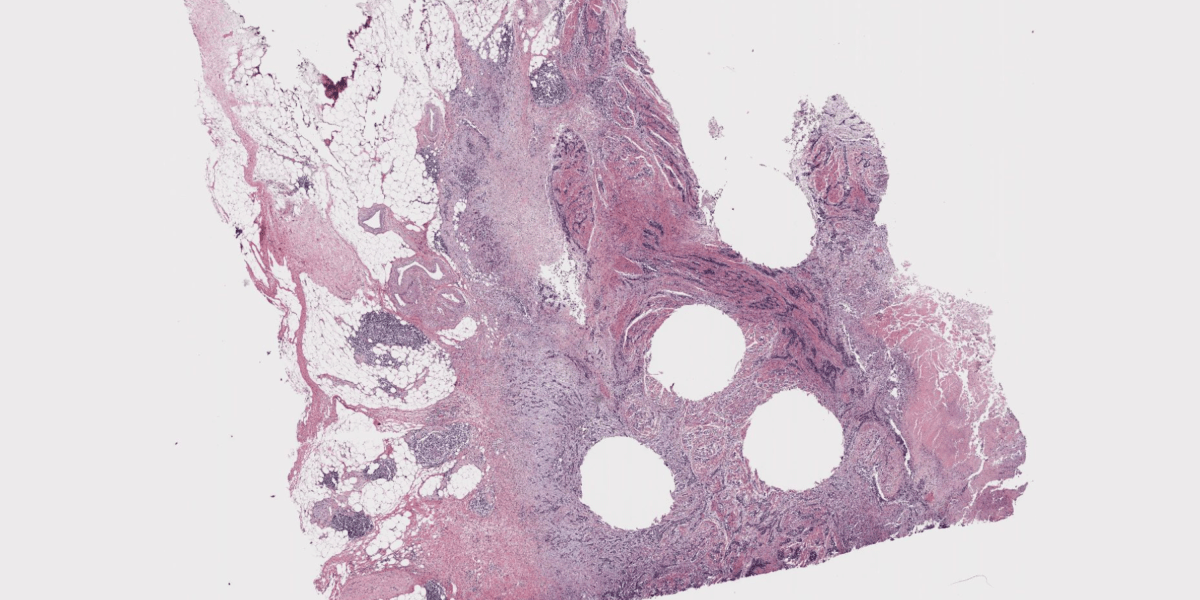

Teorik olarak yapay zekanın yardım etme konusunda harika olması gerekir. Mayo Clinic’in dijital patoloji platformunun patologu ve tıbbi direktörü Andrew Norgan, “İşimiz örüntü tanıma” diyor. “Slayda bakıyoruz ve önemli olduğu kanıtlanmış bilgi parçalarını topluyoruz.”

Görsel analiz, yaklaşık 15 yıl önce ilk görüntü tanıma modellerinin kullanılmaya başlamasından bu yana yapay zekanın oldukça iyi bir hale geldiği bir konu. Hiçbir model mükemmel olmasa da, güçlü bir algoritmanın bir gün insan patoloğun gözden kaçırdığı bir şeyi yakaladığını veya en azından tanı alma sürecini hızlandırdığını hayal edebilirsiniz. Böyle bir model oluşturmaya yönelik pek çok yeni çaba görmeye başlıyoruz (yalnızca geçen yıl en az yedi girişim), ancak hepsi deneysel kalıyor. Bunları gerçek dünyada kullanılabilecek kadar iyi hale getirmek için ne gerekecek?

Yapay zekalı sağlık şirketi Aignostics’in Mayo Clinic ile birlikte yürüttüğü böyle bir model oluşturmaya yönelik son çabanın ayrıntıları açıklandı. yayınlandı bu ayın başlarında arXiv’de. Makale hakemli değerlendirmeden geçmemiştir ancak böyle bir aracı gerçek klinik ortamlara getirmenin zorlukları hakkında çok şey ortaya koymaktadır.

Atlas adı verilen model, 490.000 vakadan 1,2 milyon doku örneği üzerinde eğitildi. Doğruluğu diğer altı önde gelen yapay zeka patoloji modeliyle karşılaştırılarak test edildi. Bu modeller, meme kanseri görüntülerinin sınıflandırılması veya tümörlerin derecelendirilmesi gibi, modelin tahminlerinin insan patologlar tarafından verilen doğru yanıtlarla karşılaştırıldığı ortak testlerde rekabet eder. Atlas, dokuz testin altısında rakip modelleri geride bıraktı. Kanserli kolorektal dokuyu kategorize etmede en yüksek puanı aldı ve %97,1 oranında insan patologlarla aynı sonuca ulaştı. Ancak başka bir görevde (prostat kanseri biyopsilerindeki tümörleri sınıflandırmak) Atlas, diğer modellerin yüksek puanlarını yalnızca %70,5’lik bir puanla geride bıraktı. Dokuz kıyaslamadaki ortalama, %84,6 oranında insan uzmanlarla aynı yanıtları aldığını gösterdi.

Bunun ne anlama geldiğini düşünelim. Dokulardaki kanserli hücrelere ne olduğunu bilmenin en iyi yolu, bir numunenin bir patolog tarafından incelenmesidir; yani yapay zeka modellerinin performansı bu şekilde ölçülür. En iyi modeller, belirli tespit görevlerinde insanlara yaklaşıyor ancak diğer birçok konuda geride kalıyor. Peki bir modelin klinik açıdan yararlı olabilmesi için ne kadar iyi olması gerekir?

“Yüzde doksan muhtemelen yeterince iyi değil. Daha da iyi olmanız gerekiyor,” diyor Providence Genomics’in baş sağlık görevlisi ve Mayo Clinic çalışmasında incelenen diğer AI patoloji modellerinden biri olan GigaPath’in yaratıcılarından Carlo Bifulco. Ancak Bifulco, mükemmel puan almayan yapay zeka modellerinin kısa vadede hala faydalı olabileceğini ve potansiyel olarak patologların çalışmalarını hızlandırmasına ve teşhisleri daha hızlı koymasına yardımcı olabileceğini söylüyor.

Daha iyi performansın önünde hangi engeller var? Bir numaralı sorun eğitim verileridir.

Norgan, “ABD’deki patoloji uygulamalarının %10’undan azı dijitalleştiriliyor” diyor. Bu, doku örneklerinin slaytlara yerleştirildiği, mikroskoplar altında analiz edildiği ve daha sonra hiçbir zaman dijital olarak belgelenmeden çok büyük kayıtlarda saklandığı anlamına geliyor. Her ne kadar Avrupa uygulamaları daha dijitalleşme eğiliminde olsa da çabalar Yapay zeka modellerinin eğitilmesi için doku örneklerinden oluşan paylaşılan veri kümeleri oluşturma çalışmaları devam ediyor, ancak hala üzerinde çalışılacak tonla şey yok.

Kaynak: https://www.technologyreview.com/2025/01/21/1110192/why-its-so-hard-to-use-ai-to-diagnose-cancer/