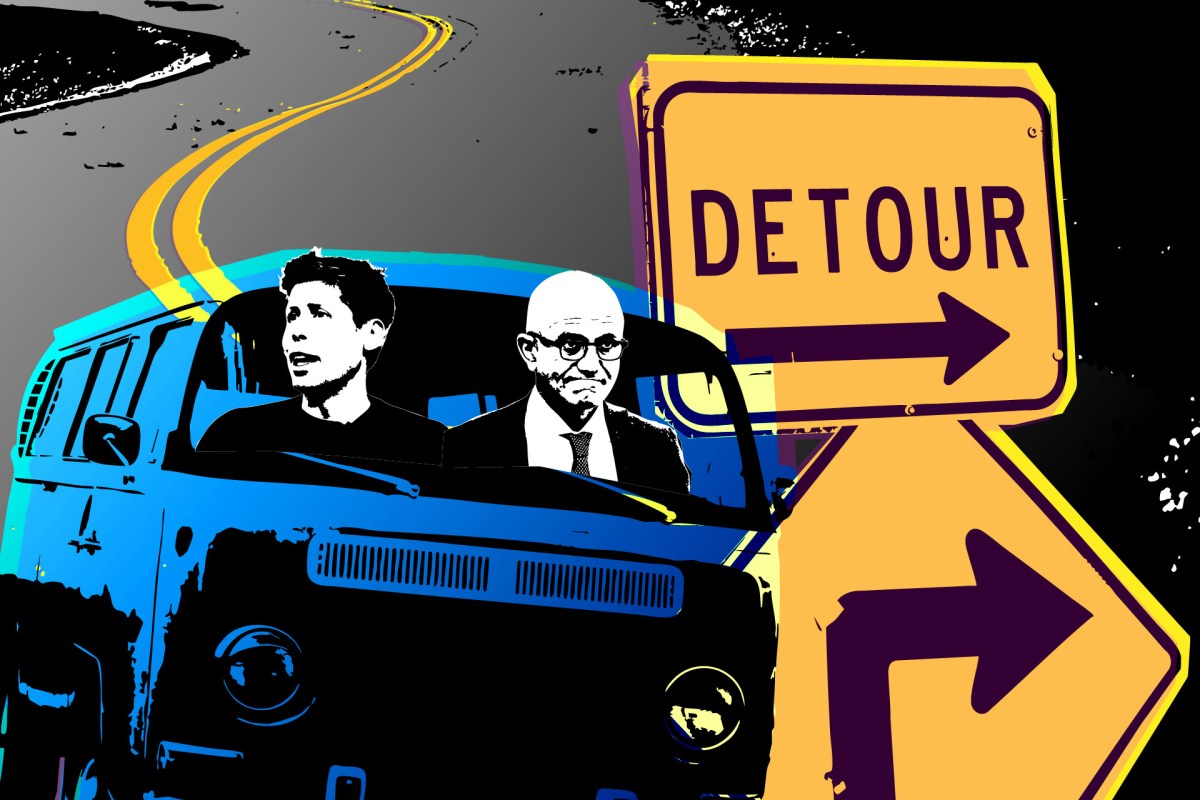

Süper akıllı sistemlere giden yolda ilerleyen yapay zeka laboratuvarları, dolambaçlı yoldan gitmeleri gerekebileceğinin farkına varıyor.

TechCrunch ile konuşan çeşitli yapay zeka yatırımcıları, kurucuları ve CEO’larına göre laboratuvarların son beş yıldır modellerinin yeteneklerini artırmak için kullandıkları yöntemler ve beklentiler olan “Yapay Zeka ölçeklendirme yasaları” artık azalan getiri işaretleri gösteriyor. Görüşleri, önde gelen yapay zeka laboratuvarlarındaki modellerin eskisine göre daha yavaş geliştiğini gösteren son raporları yansıtıyor.

Artık herkes, büyük dil modellerini önceden eğitirken daha fazla bilgi işlem ve daha fazla veri kullanamayacağınızı ve bunların bir tür her şeyi bilen dijital tanrıya dönüşmesini bekleyemeyeceğinizi kabul ediyor gibi görünüyor. Belki bu çok açık görünebilir, ancak bu ölçeklendirme yasaları ChatGPT’nin geliştirilmesinde, onu daha iyi hale getirmede ve muhtemelen birçok CEO’yu AGI’nin sadece birkaç yıl içinde geleceği konusunda cesur tahminler yapma konusunda etkilemede önemli bir faktördü.

OpenAI ve Safe Super Intelligence kurucu ortağı Ilya Sutskever, geçen hafta Reuters’e yaptığı açıklamada, yapay zeka modellerini ölçeklendirmek için “herkesin bir sonraki şeyi aradığını” söyledi. Bu ayın başlarında, a16z kurucu ortağı Marc Andreessen bir podcast’te yapay zeka modellerinin şu anda yetenekler açısından aynı tavana yakınlaştığını söyledi.

Ancak şimdi, bu endişe verici trendlerin ortaya çıkmaya başlamasından hemen sonra, yapay zeka CEO’ları, araştırmacılar ve yatırımcılar, ölçeklendirme yasalarında yeni bir çağda olduğumuzu zaten ilan ediyorlar. Yapay zeka modellerine bir soruyu yanıtlamadan önce “düşünmeleri” için daha fazla zaman ve hesaplama olanağı tanıyan “test süresi hesaplaması”, bir sonraki büyük şey olma konusunda özellikle umut verici bir rakip.

Salı günü Microsoft Ignite sahnesinde Microsoft CEO’su Satya Nadella, OpenAI’nin o1 modelini destekleyen test zamanı hesaplama araştırmasına atıfta bulunarak “Yeni bir ölçeklendirme yasasının ortaya çıktığını görüyoruz” dedi.

Gelecek olarak o1’i işaret eden tek kişi o değil.

Aynı zamanda Mistral yönetim kurulunda yer alan ve Anthropic’te melek yatırımcı olan Andreessen Horowitz ortağı Anjney Midha, yakın zamanda TechCrunch ile yaptığı bir röportajda “Şu anda ölçeklendirme yasalarının ikinci çağındayız, yani test zamanı ölçeklendirmesindeyiz” dedi. .

Önceki yapay zeka ölçeklendirme yasalarının beklenmedik başarısı ve şimdi ani yavaşlaması bize bir şey söylüyorsa, o da yapay zeka modellerinin nasıl ve ne zaman gelişeceğini tahmin etmenin çok zor olduğudur.

Ne olursa olsun, bir paradigma değişikliği yaşanıyor gibi görünüyor: Yapay zeka laboratuvarlarının önümüzdeki beş yıl boyunca modellerini geliştirmeye çalışmaları muhtemelen son beş yıla benzemeyecek.

OpenAI, Google, Meta ve Anthropic’in 2020’den bu yana elde ettiği hızlı yapay zeka modeli iyileştirmeleri büyük ölçüde tek bir temel içgörüye bağlanabilir: Yapay zeka modelinin ön eğitim aşamasında daha fazla bilgi işlem ve daha fazla veri kullanın.

Araştırmacılar, yapay zekanın büyük veri kümelerindeki kalıpları tanımlayıp sakladığı bu aşamada makine öğrenimi sistemlerine bol miktarda kaynak verdiğinde, modeller bir sonraki kelimeyi veya ifadeyi tahmin etmede daha iyi performans gösterme eğiliminde oldu.

Mühendisler kullanılan GPU sayısını ve bunlara beslenen veri miktarını artırdıkça, bu ilk nesil yapay zeka ölçeklendirme yasaları bilgisayarların yapabileceklerinin sınırlarını zorladı. Bu özel yöntem, rotasını tamamlamış olsa bile, haritayı çoktan yeniden çizmiştir. Her Büyük Teknoloji şirketi temelde tamamen yapay zekaya yönelirken, tüm bu şirketlerin modellerini eğittiği GPU’ları sağlayan Nvidia, artık dünyanın en değerli halka açık şirketi haline geldi.

Ancak bu yatırımlar aynı zamanda ölçeklenmenin beklendiği gibi devam edeceği beklentisiyle de yapıldı.

Ölçeklendirme yasalarının doğa, fizik, matematik veya hükümet yasaları olmadığını unutmamak önemlidir. Aynı hızda devam edecekleri hiçbir şey veya hiç kimse tarafından garanti edilmiyor. Bir başka ünlü ölçeklendirme yasası olan Moore Yasası bile, kesinlikle daha uzun bir süreye sahip olmasına rağmen, sonunda geçerliliğini yitirdi.

Anyscale kurucu ortağı ve eski CEO’su Robert Nishihara, TechCrunch ile yaptığı röportajda “Daha fazla bilgi işlem koyarsanız, daha fazla veri koyarsanız, modeli büyütürsünüz; getirilerde azalma olur” dedi. “Ölçeklendirme yasalarının devam etmesi, ilerleme hızının artmasını sağlamak için yeni fikirlere de ihtiyacımız var.”

Nishihara, yapay zeka ölçeklendirme yasalarına oldukça aşinadır. Anyscale, OpenAI ve diğer AI modeli geliştiricilerinin AI eğitim iş yüklerini on binlerce GPU’ya ölçeklendirmelerine yardımcı olan yazılımlar geliştirerek milyar dolarlık bir değerlemeye ulaştı. Anyscale, bilgi işlemle ilgili ölçeklendirme yasalarının ön eğitiminin en büyük faydalanıcılarından biri oldu, ancak kurucu ortağı bile sezonun değişmekte olduğunun farkında.

Nishihara, verileri ölçeklendirmenin sınırlamalarına atıfta bulunarak, “Yelp’te bir milyon yorum okuduğunuzda, belki de Yelp’teki bir sonraki incelemeler size o kadar fazla bilgi vermez” dedi. “Ama bu ön eğitim. Eğitim sonrası metodolojinin oldukça olgunlaşmamış olduğunu ve geliştirilmesi gereken çok şey olduğunu söyleyebilirim.”

Açık olmak gerekirse, AI modeli geliştiricileri büyük olasılıkla ön eğitim için daha büyük bilgi işlem kümesinin ve daha büyük veri kümelerinin peşinde koşmaya devam edecek ve muhtemelen bu yöntemlerden daha fazla gelişme sağlanacak. Elon Musk, xAI’nin sonraki modellerini eğitmek için Colossus adlı 100.000 GPU’lu bir süper bilgisayar oluşturmayı yakın zamanda tamamladı. Gelecek daha fazla ve daha büyük kümeler olacak.

Ancak trendler, mevcut stratejilerle daha fazla GPU kullanarak üstel büyümenin mümkün olmadığını, dolayısıyla yeni yöntemlerin birdenbire daha fazla ilgi görmeye başladığını gösteriyor.

OpenAI, o1 modelinin ön izlemesini yayınladığında startup, bunun GPT’den ayrı yeni bir model serisinin parçası olduğunu duyurdu.

OpenAI, GPT modellerini büyük ölçüde geleneksel ölçeklendirme yasalarıyla geliştirdi: daha fazla veri, ön eğitim sırasında daha fazla güç. Ancak artık bu yöntemin onlara pek bir şey kazandırmadığı bildiriliyor. o1 model çerçevesi, bilgi işlem kaynaklarının daha önce değil, bir komut isteminden sonra kullanıldığı için test zamanı hesaplama adı verilen yeni bir konsepte dayanır. Teknik henüz sinir ağları bağlamında çok fazla araştırılmadı, ancak şimdiden umut vaat ediyor.

Bazıları zaten yapay zeka sistemlerini ölçeklendirmek için bir sonraki yöntem olarak test zamanında hesaplamayı işaret ediyor.

a16z’den Midha, “Bir dizi deney, ölçeklendirme yasalarının eğitim öncesi yavaşlıyor olmasına rağmen, modele çıkarımda daha fazla hesaplama verdiğiniz test süresi ölçeklendirme yasalarının performansta artan kazançlar sağlayabileceğini gösteriyor” dedi.

“OpenAI’nin yeni ‘o’ serisi itiyor [chain-of-thought] Ünlü yapay zeka araştırmacısı Yoshua Benjio, Salı günü yazdığı köşe yazısında şunları söyledi: “Daha da ileri gidiyor ve bunu yapmak için çok daha fazla bilgi işlem kaynağı ve dolayısıyla enerji gerekiyor.” “Böylece yeni bir hesaplamalı ölçeklendirme biçiminin ortaya çıktığını görüyoruz. Sadece daha fazla eğitim verisi ve daha büyük modeller değil, aynı zamanda cevaplar hakkında ‘düşünmek’ için daha fazla zaman harcanıyor.”

OpenAI’nin o1 modeli, 10 ila 30 saniyelik bir süre boyunca kendisini birkaç kez yeniden uyararak büyük bir sorunu bir dizi küçük soruna böler. ChatGPT “düşünmek” olduğunu söylese de, insanların yaptığını yapmıyor – her ne kadar bir sorunun net bir şekilde yeniden ifade edilmesinden ve adım adım çözümlerden yararlanan dahili problem çözme yöntemlerimiz, yöntem için temel ilham kaynağı olsa da.

On yıl kadar önce, şu anda OpenAI’nin o1 üzerindeki çalışmalarına liderlik eden Noam Brown, insanları pokerde yenebilecek yapay zeka sistemleri oluşturmaya çalışıyordu. Yakın zamanda yapılan bir konuşma sırasında Brown, insan poker oyuncularının bir el oynamadan önce farklı senaryoları düşünmek için nasıl zaman harcadıklarını fark ettiğini söyledi. 2017 yılında bir modelin oynamadan önce 30 saniye boyunca “düşünmesine” izin veren bir yöntem tanıttı. O dönemde yapay zeka, en iyi hamleyi belirlemek için farklı senaryoların nasıl işleyeceğini hesaplayarak farklı alt oyunlar oynuyordu.

Sonuçta yapay zeka, önceki denemelerinden yedi kat daha iyi performans gösterdi.

Kabul edelim ki Brown’ın 2017’deki araştırması, o zamanlar pek popüler olmayan sinir ağlarını kullanmıyordu. Ancak MIT araştırmacıları geçen hafta test süresi hesaplamasının yapay zeka modelinin akıl yürütme görevlerindeki performansını önemli ölçüde artırdığını gösteren bir makale yayınladı.

Test süresi hesaplamasının nasıl ölçekleneceği hemen belli değil. Bu, yapay zeka sistemlerinin zor sorular üzerinde düşünmek için gerçekten uzun bir zamana ihtiyaç duyduğu anlamına gelebilir; belki saatler, hatta günler. Başka bir yaklaşım, bir yapay zeka modelinin aynı anda birçok çip üzerindeki sorular üzerinde “düşünmesine” izin vermek olabilir.

Midha, test zamanındaki hesaplamanın yapay zeka sistemlerini ölçeklendirmenin bir sonraki yeri olarak yükselişe geçmesi durumunda, yüksek hızlı çıkarımda uzmanlaşmış yapay zeka çiplerine olan talebin önemli ölçüde artabileceğini söylüyor. Bu, hızlı yapay zeka çıkarım çipleri konusunda uzmanlaşmış Groq veya Cerebras gibi girişimler için iyi bir haber olabilir. Cevabı bulmak, modeli eğitmek kadar bilgi işlem açısından yoğunsa, yapay zekadaki “toplama ve kürekleme” sağlayıcıları yine kazanır.

Yapay zeka dünyasının çoğu, bu eski ölçeklendirme yasalarının yavaşlaması konusunda soğukkanlılığını kaybetmiyor gibi görünüyor. Test zamanındaki hesaplamanın bir sonraki ölçeklendirme dalgası olmadığı kanıtlansa bile, bazıları mevcut yapay zeka modellerine yönelik uygulamaların yalnızca yüzeyini çizdiğimizi düşünüyor.

Yeni popüler ürünler, yapay zeka modeli geliştiricilerine, temeldeki modelleri iyileştirmenin yeni yollarını bulmaları için biraz zaman kazandırabilir.

“Sadece uygulama düzeyindeki çalışmalar sayesinde model performansında en az 10 ila 20 kat artış göreceğimize, modellerin akıllı yönlendirme, UX kararları ve bağlamı doğru zamanda aktarma yoluyla parlamasına olanak tanıyacağımıza tamamen inanıyorum. modeller,” dedi Midha.

Örneğin ChatGPT’nin Gelişmiş Ses Modu mevcut yapay zeka modellerindeki en etkileyici uygulamalardan biridir. Ancak bu, temelde yatan teknoloji değil, büyük ölçüde kullanıcı deneyimindeki bir yenilikti. Bu özelliğe web’e veya telefonunuzdaki uygulamalara erişim olanağı vermek gibi daha fazla UX yeniliklerinin, ürünü ne kadar daha iyi hale getireceğini görebilirsiniz.

AI start-up Workera’nın CEO’su ve Stanford’da derin öğrenme konusunda yardımcı öğretim görevlisi olan Kian Katanforoosh, TechCrunch’a kendisi gibi AI uygulamaları geliştiren şirketlerin daha iyi ürünler oluşturmak için katlanarak daha akıllı modellere ihtiyaç duymadığını söylüyor. Ayrıca mevcut modellerin etrafındaki ürünlerin daha iyi hale gelmesi için çok fazla alana sahip olduğunu söylüyor.

Katanforoosh, “Diyelim ki yapay zeka uygulamaları geliştiriyorsunuz ve yapay zekanız belirli bir görevle ilgili halüsinasyon görüyor” dedi. “Bunu önlemenin iki yolu var. Ya Yüksek Lisans daha iyi olmalı ve halüsinasyona son vermeli ya da etrafındaki araçlar daha iyi olmalı ve siz de sorunu çözme fırsatlarına sahip olacaksınız.

Yapay zeka araştırmalarının sınırları için durum ne olursa olsun, kullanıcılar muhtemelen bu değişimlerin etkilerini bir süre daha hissetmeyecekler. Bununla birlikte yapay zeka laboratuvarları daha büyük, daha akıllı ve daha hızlı modelleri aynı hızla sunmaya devam etmek için ne gerekiyorsa yapacak. Bu, birçok önde gelen teknoloji şirketinin artık yapay zekanın sınırlarını nasıl zorlayacaklarını değiştirebilecekleri anlamına geliyor.

Kaynak: https://techcrunch.com/2024/11/20/ai-scaling-laws-are-showing-diminishing-returns-forcing-ai-labs-to-change-course/

Web sitemizde ziyaretçilerimize daha iyi hizmet sağlayabilmek adına bazı çerezler kullanıyoruz. Web sitemizi kullanmaya devam ederseniz çerezleri kabul etmiş sayılırsınız.

Gizlilik Politikası