Teknoloji uzmanları birkaç yıldır gelişmiş yapay zeka sistemlerinin insan ırkına büyük zarar verme potansiyeli konusunda alarm zilleri çalıyor.

Ancak 2024’te bu uyarı çağrıları, teknoloji endüstrisinin teşvik ettiği pratik ve başarılı üretken yapay zeka vizyonuyla bastırıldı; bu vizyon aynı zamanda cüzdanlarına da fayda sağladı.

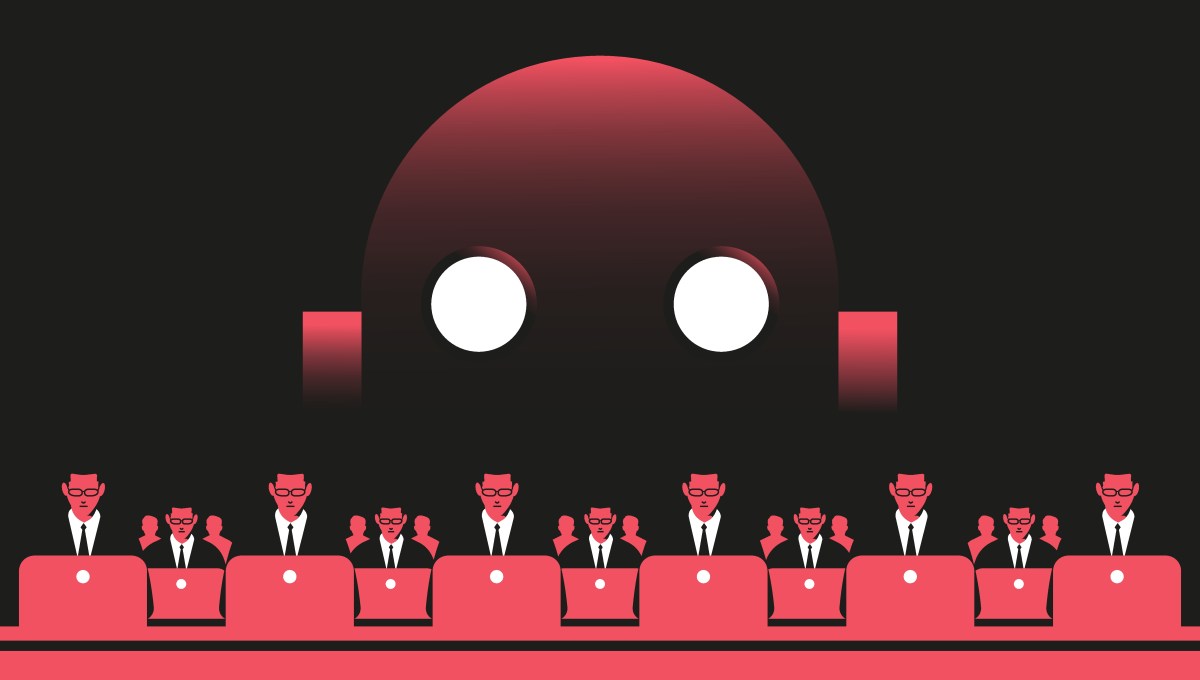

Yapay zekanın yıkıcı riskine ilişkin uyarılara genellikle “Yapay Zekanın felaket tellalları” deniyor, ancak bu pek hoşlarına giden bir isim değil. Yapay zeka sistemlerinin insanları öldürme kararları vereceğinden, güçlüler tarafından kitlelere baskı yapmak için kullanılacağından veya toplumun bir şekilde çöküşüne katkıda bulunacağından endişe ediyorlar.

2023 yılında teknoloji düzenlemelerinde bir rönesans döneminin başlangıcındaymışız gibi görünüyordu. Yapay zekanın sonu ve yapay zeka güvenliği (halüsinasyonları, yetersiz içerik denetimini ve yapay zekanın topluma zarar verebileceği diğer yolları kapsayabilen daha geniş bir konu), San Francisco kafelerinde tartışılan niş bir konudan MSNBC, CNN ve ön sayfalarda çıkan bir sohbete dönüştü. New York Times’ın.

2023’te yapılan uyarıları özetlersek: Elon Musk ve 1000’den fazla teknoloji uzmanı ve bilim insanı, yapay zeka gelişimine bir ara verilmesi çağrısında bulunarak, dünyadan teknolojinin derin risklerine hazırlanmasını istedi. Kısa bir süre sonra OpenAI, Google ve diğer laboratuvarlardaki önde gelen bilim insanları, yapay zekanın insan neslinin tükenmesine yol açma riskine daha fazla itibar edilmesi gerektiğini belirten açık bir mektup imzaladılar. Aylar sonra Başkan Biden, Amerikalıları yapay zeka sistemlerinden korumayı amaçlayan bir yapay zeka yürütme emri imzaladı. Kasım 2023’te, dünyanın lider yapay zeka geliştiricisi OpenAI’nin arkasındaki kar amacı gütmeyen kurul, Sam Altman’ı, CEO’sunun yalan söylemekle ünlü olduğunu ve yapay genel zeka veya AGI kadar önemli bir teknoloji konusunda güvenilemeyeceğini iddia ederek kovdu. AI’nın hayal edilen son noktası, yani aslında öz farkındalığı gösteren sistemler. (Her ne kadar tanım artık bu konuda konuşanların iş ihtiyaçlarını karşılayacak şekilde değişiyor olsa da.)

Bir an için Silikon Vadisi girişimcilerinin hayalleri toplumun genel sağlığı açısından arka planda kalacakmış gibi göründü.

Ancak bu girişimciler için yapay zekanın sonu hakkındaki hikaye, yapay zeka modellerinin kendisinden daha endişe vericiydi.

Buna yanıt olarak, a16z kurucu ortağı Marc Andreessen, Haziran 2023’te, yapay zekanın felakete uğrayanlarının gündemini ortadan kaldıran ve teknolojinin nasıl işleyeceğine dair daha iyimser bir vizyon sunan 7.000 kelimelik bir makale olan “Yapay Zeka Dünyayı Neden Kurtaracak?” başlıklı makaleyi yayınladı.

“Yapay Zeka çağı geldi ve insanlar çıldırıyor. Neyse ki iyi haberi vermek için buradayım: Yapay zeka dünyayı yok etmeyecek, aslında onu kurtarabilir” dedi Andreessen makalesinde.

Sonuç bölümünde Andreessen, yapay zeka korkularımıza uygun bir çözüm sundu: hızlı hareket edin ve işleri bozun; temelde diğer tüm 21. yüzyıl teknolojilerini (ve bunlara bağlı sorunları) tanımlayan ideolojinin aynısı. Büyük Teknoloji şirketlerinin ve startup şirketlerinin mümkün olduğunca hızlı ve agresif bir şekilde yapay zeka oluşturmalarına izin verilmesi gerektiğini, çok az veya hiç düzenleyici engel olmadan savunuldu. Bunun, yapay zekanın birkaç güçlü şirketin veya hükümetin eline geçmemesini sağlayacağını ve Amerika’nın Çin ile etkili bir şekilde rekabet etmesine olanak sağlayacağını söyledi.

Elbette bu, a16z’nin birçok yapay zeka girişiminin çok daha fazla para kazanmasına da olanak tanıyacak ve bazıları, aşırı gelir eşitsizliği, salgın hastalıklar ve konut krizlerinin olduğu bir dönemde onun tekno-iyimserliğini kaba buldu.

Andreessen her zaman Big Tech ile aynı fikirde olmasa da para kazanmak tüm sektörün üzerinde anlaşabileceği bir alan. a16z’nin kurucu ortakları bu yıl Microsoft CEO’su Satya Nadella’ya bir mektup yazarak hükümetten yapay zeka endüstrisini hiçbir şekilde düzenlememesini istediler.

Bu arada, 2023’teki çılgınca el sallamalarına rağmen, Musk ve diğer teknoloji uzmanları 2024’te güvenliğe odaklanmak için yavaşlamayı bırakmadılar; tam tersi: 2024’teki yapay zeka yatırımı, daha önce gördüğümüz her şeyi geride bıraktı. Altman hızla OpenAI’nin yönetimine geri döndü ve bir grup güvenlik araştırmacısı, azalan güvenlik kültürüyle ilgili alarm zilleri çalarken 2024’te ekipten ayrıldı.

Biden’ın güvenlik odaklı yapay zeka yönetim emri bu yıl Washington DC’de büyük ölçüde gözden düştü; yeni seçilen Başkan Donald Trump, bunun yapay zeka inovasyonunu engellediğini öne sürerek Biden’ın emrini yürürlükten kaldırma planlarını duyurdu. Andreessen, son aylarda Trump’a yapay zeka ve teknoloji konusunda danışmanlık yaptığını ve a16z’de uzun süredir risk sermayedarı olan Sriram Krishnan’ın artık Trump’ın yapay zeka konusunda resmi kıdemli danışmanı olduğunu söylüyor.

George Mason Üniversitesi Mercatus Merkezi’nde yapay zeka odaklı araştırma görevlisi olan Dean Ball’a göre, Washington’daki Cumhuriyetçilerin yapay zeka ile ilgili birçok önceliği var ve bugün yapay zekanın kıyametini geride bırakıyor. Bunlar arasında yapay zekayı güçlendirmek için veri merkezleri oluşturmak, yapay zekayı hükümette ve orduda kullanmak, Çin ile rekabet etmek, merkez sol teknoloji şirketlerinin içerik denetlemesini sınırlamak ve çocukları yapay zeka sohbet robotlarından korumak yer alıyor.

“Bence [the movement to prevent catastrophic AI risk] federal düzeyde zemin kaybetti. Eyalet ve yerel düzeyde de büyük bir mücadeleyi kaybettiler” dedi Ball, TechCrunch ile yaptığı röportajda. Tabii ki Kaliforniya’nın tartışmalı yapay zeka güvenlik kanunu SB 1047’ye atıfta bulunuyor.

Yapay zekanın 2024’te gözden düşmesinin nedenlerinden biri, yapay zeka modelleri daha popüler hale geldikçe, bunların ne kadar zeki olmadıklarını da görmemizdi. Size pizzanıza yapıştırıcı sürmenizi söyleyen Google Gemini’nin Skynet’e dönüşeceğini hayal etmek zor.

Ancak 2024 aynı zamanda birçok yapay zeka ürününün bilim kurgudan kavramları hayata geçirdiği bir yıl oldu. Bu yıl ilk kez: OpenAI, telefonlarımız aracılığıyla değil de onlarla nasıl konuşabileceğimizi gösterdi ve Meta, gerçek zamanlı görsel anlayışa sahip akıllı gözlükleri tanıttı. Yıkıcı yapay zeka riskinin altında yatan fikirler büyük ölçüde bilim kurgu filmlerinden kaynaklanıyor ve açıkça bir sınır olsa da yapay zeka dönemi, bilim kurgudan gelen bazı fikirlerin sonsuza kadar kurgusal olmayabileceğini kanıtlıyor.

2024’ün en büyük yapay zeka kıyamet savaşı: SB 1047

2024’teki yapay zeka güvenlik savaşı, son derece saygın iki yapay zeka araştırmacısı Geoffrey Hinton ve Yoshua Benjio tarafından desteklenen bir yasa tasarısı olan SB 1047 ile doruğa ulaştı. Tasarı, gelişmiş yapay zeka sistemlerinin, 2024’teki CrowdStrike kesintisinden daha fazla hasara neden olabilecek kitlesel insan yok oluşu olaylarına ve siber saldırılara neden olmasını engellemeye çalışıyordu.

SB 1047, Kaliforniya Yasama Meclisi’nden geçerek Vali Gavin Newsom’un masasına kadar geldi ve Newsom bunu “büyük etkiye sahip” bir yasa tasarısı olarak nitelendirdi. Tasarı, Musk, Altman ve diğer birçok Silikon Vadisi liderinin 2023’te yapay zekaya ilişkin açık mektupları imzalarken uyardıkları şeyleri engellemeye çalışıyordu.

Ancak Newsom, SB 1047’yi veto etti. Kararından önceki günlerde, San Francisco şehir merkezinde sahnede yapay zeka düzenlemesinden bahsetti ve şunları söyledi: “Her şeyi çözemem. Neyi çözebiliriz?”

Bu, bugün ne kadar çok politika yapıcının yıkıcı yapay zeka riski hakkında düşündüğünü oldukça açık bir şekilde özetliyor. Pratik çözümü olan bir sorun değil.

Buna rağmen SB 1047, yıkıcı yapay zeka riskine odaklanmanın ötesinde kusurluydu. Tasarı, yalnızca en büyük oyuncuları düzenlemek amacıyla yapay zeka modellerini boyuta göre düzenledi. Ancak bu, önde gelen yapay zeka laboratuvarlarının halihazırda yöneldiği test zamanı hesaplaması veya küçük yapay zeka modellerinin yükselişi gibi yeni teknikleri hesaba katmadı. Dahası, yasa tasarısı geniş çapta açık kaynaklı yapay zekaya (ve dolaylı olarak araştırma dünyasına) yönelik bir saldırı olarak değerlendirildi çünkü Meta ve Mistral gibi firmaların son derece özelleştirilebilir öncü yapay zeka modelleri yayınlaması sınırlı olacaktı.

Ancak tasarının yazarı Eyalet Senatörü Scott Wiener’e göre Silikon Vadisi, SB 1047 hakkındaki kamuoyunu etkilemek için kirli bir oyun sergiledi. Kendisi daha önce TechCrunch’a Y Combinator ve A16Z’den risk sermayedarlarının tasarıya karşı bir propaganda kampanyası yürüttüklerini söylemişti.

Özellikle bu gruplar, SB 1047’nin yazılım geliştiricilerini yalancı şahitlik nedeniyle hapse göndereceği iddiasını yaydı. Y Combinator, Haziran 2024’te genç kuruculardan aynı şeyi söyleyen bir mektuba imza atmalarını istedi. Aynı sıralarda Andreessen Horowitz’in genel ortağı Anjney Midha da bir podcast’te benzer bir iddiada bulundu.

Brookings Enstitüsü bunu tasarıdaki birçok yanlış beyandan biri olarak nitelendirdi. SB 1047, teknoloji yöneticilerinin yapay zeka modellerinin eksikliklerini tanımlayan raporlar sunmaları gerektiğini belirtti ve yasa tasarısında, bir hükümet belgesinde yalan söylemenin yalancı şahitlik olduğu belirtildi. Ancak bu korkuları yayan risk sermayedarları, insanların nadiren yalan yere yemin etmekle suçlandığını ve hatta daha nadiren hüküm giydiğini söylemediler.

YC, daha önce TechCrunch’a SB 1047’nin belirsiz olduğunu ve Senatör Wiener’in iddia ettiği kadar somut olmadığını söyleyerek yanlış bilgi yaydıkları fikrini reddetti.

Daha genel olarak, SB 1047 savaşı sırasında yapay zekanın felakete yol açanların sadece teknoloji karşıtı değil, aynı zamanda hayalperest olduğuna dair artan bir duygu vardı. Ünlü yatırımcı Vinod Khosla, bu yılın ekim ayında Wiener’in yapay zekanın gerçek tehlikeleri konusunda bilgisiz olduğunu söyledi.

Meta’nın baş yapay zeka bilimcisi Yann LeCun, yapay zekanın sonunun altında yatan fikirlere uzun süredir karşı çıkıyor ancak bu yıl daha açık sözlü olmaya başladı.

“Bir şekilde bu fikir [intelligent] 2024’te Davos’ta LeCun, süper akıllı yapay zeka sistemleri geliştirmekten ne kadar uzakta olduğumuzu belirterek, “sistemlerin kendi hedeflerini bulup insanlığı ele geçirmesi saçmalık, saçmalık” dedi. “İnşa etmenin pek çok yolu var [any technology] Tehlikeli, yanlış, insanları öldürecek vb. şekillerde… Ama bunu doğru yapmanın tek bir yolu olduğu sürece ihtiyacımız olan tek şey bu.”

Bu arada politika yapıcılar dikkatlerini yeni bir dizi yapay zeka güvenlik sorununa yöneltti.

2025’te önümüzdeki mücadele

SB 1047’nin arkasındaki politika yapıcılar, uzun vadeli yapay zeka risklerini ele almak için 2025’te değiştirilmiş bir yasa tasarısı ile geri gelebileceklerini ima ettiler. Tasarının arkasındaki sponsorlardan biri olan Encode, SB 1047’nin ulusal çapta gördüğü ilginin olumlu bir sinyal olduğunu söylüyor.

Encode’un Siyasi İşlerden Sorumlu Başkan Yardımcısı Sunny Gandhi, TechCrunch’a gönderdiği bir e-postada “Yapay zeka güvenlik hareketi, SB 1047’nin vetosuna rağmen 2024’te çok cesaret verici bir ilerleme kaydetti” dedi. “Halkın uzun vadeli yapay zeka risklerine ilişkin farkındalığının arttığı ve politika yapıcılar arasında bu karmaşık zorlukların üstesinden gelme konusundaki istekliliğin arttığı konusunda iyimseriz.”

Gandhi, Encode’un 2025’te yapay zeka destekli felaket riskini düzenlemek için “önemli çabalar” beklediğini ancak spesifik bir risk açıklamadığını söyledi.

Diğer tarafta, a16z’nin genel ortağı Martin Casado, yıkıcı yapay zeka riskinin düzenlenmesine karşı mücadeleye öncülük eden kişilerden biri. Yapay zeka politikası üzerine Aralık ayında yayınlanan bir köşe yazısında Casado, ileriye dönük olarak daha makul bir yapay zeka politikasına ihtiyacımız olduğunu savundu ve “Yapay zeka son derece güvenli görünüyor” dedi.

Casado, Aralık ayında attığı bir tweette, “Aptal yapay zeka politikası çabalarının ilk dalgası büyük ölçüde geride kaldı” dedi. “Umarım ileride daha akıllı olabiliriz.”

Yapay zekayı “son derece güvenli” olarak adlandırmak ve onu “aptal” olarak düzenlemeye çalışmak aşırı basitleştirmedir. Örneğin, a16z’nin yatırım yaptığı bir girişim olan Character.AI, şu anda çocuk güvenliği endişeleri nedeniyle dava ediliyor ve araştırılıyor. Aktif bir davada, 14 yaşındaki Floridalı bir çocuk, intihara yönelik düşüncelerini romantik ve cinsel sohbetler yaptığı Character.AI sohbet robotuna aktardığı iddia edildikten sonra kendini öldürdü. Bu vaka başlı başına, toplumumuzun yapay zekayla ilgili, sadece birkaç yıl önce kulağa gülünç gelebilecek yeni risk türlerine nasıl hazırlanması gerektiğini gösteriyor.

Senatör Mitt Romney tarafından kısa süre önce federal düzeyde sunulan yasa tasarısı da dahil olmak üzere, uzun vadeli yapay zeka riskini ele alan daha fazla yasa tasarısı ortalıkta dolaşıyor. Ancak şimdi, yapay zekanın felakete uğrayanları 2025’te çetin bir mücadele verecek gibi görünüyor.

Kaynak: https://techcrunch.com/2025/01/01/2024-the-year-silicon-valley-stifled-the-ai-doom-movement/